Ibilgailu autonomoen segurtasuna bermatzea

Ordenagailu bidez gidatutako automobilak eta aireontziak gero eta ohikoagoak diren honetan, ikertzaileek diote istripuak prebenitzeko gakoa ez dakiguna jakitea dela.

Gidaririk gabeko automobilak eta aireontziak ez dira etorkizuneko kontu bat. San Frantzisko hirian soilik, bi taxi enpresek gidaritza autonomoko 12,9 milioi kilometro erregistratu dituzte kolektiboki 2023ko abuztura arte. Eta, Estatu Batuetan, 850.000 aireontzi autonomo edo drone daude erregistratuta, militarrenak zenbatu gabe.

Hala ere, segurtasunari buruzko kezka justifikatuak ere badaude. Adibidez, 2022ko maiatzean amaitu zen 10 hilabeteko aldian, Estatu Batuetako Errepideetako Trafiko Segurtasunaren Administrazio Nazionalak moduren batean kontrol autonomoa erabiltzen zuten automobilak tartean izan zituzten 400 istripu jakinarazi zituen. Istripu horien ondorioz, sei pertsona hil ziren, eta beste bostek zauri larriak izan zituzten.

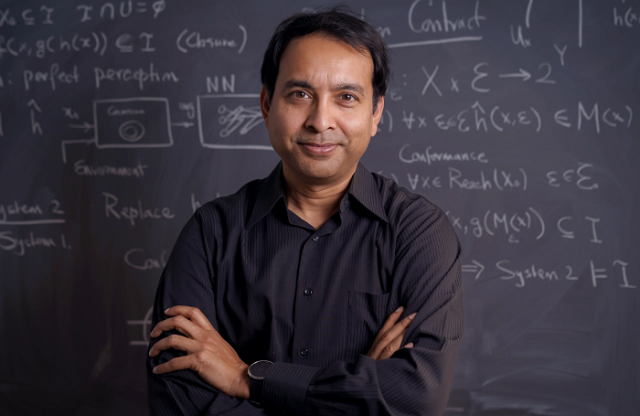

Arazo horri aurre egiteko modurik ohikoena “kasuen bidezko frogantza” da; hau da, sistema horiek behin eta berriz frogatzea seguruak direla sinetsita egon arte. Baina ezin dugu ziur jakin prozesu horren bidez akats potentzial guztiak deskubrituko direnik. «Jendeak beren baliabideak eta pazientzia agortzen dituzten probak egiten ditu», azaldu du Sayan Mitrak, Urbana-Champaigneko Illinoisko Unibertsitateko informatikari zientzialariak. Hala ere, probek, beren kabuz, ezin dute bermerik eman.

Mitra eta haren kideek, berriz, bai. Mitraren taldeak automobilen erreiak jarraitzeko gaitasunaren eta aireontzi autonomoen lurreratze sistemen segurtasuna frogatu du. Egun, taldeak aplikatutako estrategia hori erabiltzen ari da hegazkin ontzietan droneak lurreratzeko, eta Boeing-ek hegazkin esperimental batekin ere probatu nahi du aurten. «Muturretik muturrera segurtasun bermeak emateko metodo hori oso garrantzitsua da», adierazi du Corina Pasareanuk, Carnegie Mellon Unibertsitateko eta NASAren Ames Ikerguneko zientzialari ikertzaileak.

Bere lana da ibilgailu autonomoei informazioa helarazteko erabiltzen diren ikasketa automatikoko algoritmoen emaitzak bermatzea. Oro har, ibilgailu autonomo askok bi osagai dituzte: pertzepzio sistema bat eta kontrol sistema bat. Pertzepzio sistemak esaten dizu, adibidez, zein distantziara dagoen zure autoa erreiaren erdigunearekiko, edo zer norabidetan doan hegazkin bat eta zein den haren angelua horizontearekiko. Sistemak honela funtzionatzen du: kamera eta beste tresna sentsorialetatik hartutako prozesatu gabeko datuak elikatzen dizkie ibilgailuaren kanpoaldea birsortzen duten sare neuronaletan oinarritutako ikasketa automatikoko algoritmoei.

Ondoren, ebaluazio horiek sistema independente bati bidaltzen zaizkio, kontrol moduluari, eta horrek erabakitzen du nola jokatu. Oztopo batekin talka egingo bada, adibidez, sistema horrek erabakitzen du frenoak aplikatuko dituen edo biratu egingo duen oztopoa saihesteko. Massachusettseko Teknologia Institutuko Luca Carlone irakasle elkartuaren hitzetan, kontrol modulua ondo ezarritako teknologian oinarritzen bada ere, «pertzepzioaren emaitzetan oinarritutako erabakiak hartzen ditu, eta ez dago bermerik frogatzeko emaitza horiek zuzenak direnik».

Segurtasun berme hori emate aldera, Mitraren taldeak ibilgailuaren pertzepzio sistemaren fidagarritasuna bermatzeko lan egin du. Hasieran suposatu zuten segurtasuna bermatzea posible dela kanpoaldeko irudikapen perfektua izanez gero. Ondoren, zehaztu zuten zenbatekoa den pertzepzio sistemak ibilgailuaren ingurua birsortzean izan dezakeen errorea.

Estrategiaren gakoa da tartean dauden ziurgabetasunak kuantifikatzea, errore bandak deritzenak, edo “ezezagun ezagunak”, Mitrak adierazten duen moduan. Kalkulu horren jatorria Mitrak eta bere taldeak pertzepzio kontratu deritzena da. Software ingeniaritzan, kontratu bat konpromiso hau da: ordenagailu programa baterako sarbide jakin baterako, irteera tarte espezifikatu batean egongo da. Baina tarte hori kalkulatzea ez da lan erraza. Zenbateko zehaztasuna dute autoko sentsoreek? Zenbateko lainoa, euria edo eguzki distira jasan dezake drone batek? Baina ibilgailua ziurgabetasun tarte espezifiko baten barruan manten badezakezu, eta tarte horren zehaztapena behar bezain doia bada, Mitraren taldeak frogatu zuen ibilgailu horren segurtasuna berma dezakezula.

Oso zehatza ez den abiadura-neurgailu bat daukan orok ondo ezagutzen du egoera hori. Baldin badakizu gailua ez dela inoiz 5 kilometro ordu baino gehiago desbideratzen, abiadura muga gainditzeagatiko isuna ekidin dezakezu beti abiadura mugatik 5 km/h beherago mantenduta (erabat fidagarria ez den zure abiadura neurgailuak adierazten duenari jarraikiz). Bada, pertzepzio kontratu batek antzeko segurtasun berme bat ematen du ikasketa automatikoaren menpeko sistema inperfektu batean.

«Ez da pertzepzio perfektua behar», azaldu du Carlonek. «Lortu nahi dena da pertzepzioa segurtasuna arriskuan ez jartzeko bezain ona izatea». Bere ustez, taldeak eginiko ekarpen nagusiak izan dira «pertzepzio kontratuen ideia osoa aplikatzea» eta horiek eraikitzeko metodoak ematea. Horretarako, egiaztapen formal izeneko informatikaren adarreko teknikak erabili dituzte. Adar horrek forma matematiko bat ematen du sistema baten portaerak betekizunen multzo bat asetzen duela egiaztatzeko.

«Hala ere, ez dakigu zehatz-mehatz nola egiten duen sare neuronalak egiten duen hori»; Mitrak adierazi duen moduan, frogatu dute oraindik posible dela zenbaki bidez frogatzea sare neuronal bateko irteerako ziurgabetasuna muga batzuen barruan dagoela. Eta, hala bada, orduan sistema segurua izango da. «Hortaz, berme estatistiko bat eman dezakegu sare neuronal jakin batek benetan muga horiek beteko dituen (eta zer neurritan) adierazteko».

Sierra Nevada enpresa aeroespaziala segurtasun berme horiek probatzen ari da orain, drone bat hegazkin-ontzi batean lurreratzean. Arazo hori, neurri batean, automobilak gidatzea baino zailagoa da, hegan egiteak berekin dakarren dimentsio gehigarria dela eta. “Lurreratzean, bi eginkizun nagusi daude”, azaldu du Dragos Margineantuk, Boeing-eko AAren teknologo buruak, “hegazkina pistarekin lerrokatzea eta pistan oztoporik ez dagoela bermatzea. Sayanekin egindako lanaren bidez bi funtzio horietarako bermeak lortu nahi ditugu”.

«Sayanen algoritmoa erabiltzen duten simulazioetan lerrokatzea [hegazkin batena lurreratu aurretik] hobetzen da», adierazi du. Hurrengo urratsa da sistema horiek erabiltzea Boeing-en hegazkin esperimental bat lurreratu bitartean; eta froga hori urte honen amaierarako aurreikusi dute. Erronka nagusietako bat, Margineanturen arabera, ez dakiguna deskubritzea izango da – “gure estimazioetan ziurgabetasuna zehaztea” –, eta ikustea zer-nolako eragina duen horrek segurtasunean. «Akats gehienak gertatzen dira ustez badakizkigun gauzak egiten ditugunean, eta ez genekizkiela deskubritzen dugu».

Jatorrizko artikulua:

Steve Nadis (2024). How to Guarantee the Safety of Autonomous Vehicles, Quanta Magazine, 2024ko urtarrilaren 16a. Quanta Magazine aldizkariaren baimenarekin berrinprimatua.