Zergatik interesatzen zaizkie ikertzaileei hizkuntza eredu txikiak?

Eredu handienek eginkizunen sorta zabalago bat egin dezakete, baina eredu txikiagoen tamaina txikiak tresna erakargarri bihurtzen ditu.

Hizkuntza eredu handiek ondo funtzionatzen dute oso handiak direlako. OpenAI, Meta eta DeepSeek-en eredu berrienek ehun mila milioika “parametro” erabiltzen dituzte. Parametro horiek datuen arteko konexioak zehazten dituzten eta entrenamendu prozesuan aldatzen diren botoi doigarriak dira. Parametro gehiagorekin, ereduek hobeto identifika ditzakete patroiak eta konexioak; eta horrek, aldi berean, potenteagoak eta zehatzagoak bihurtzen ditu.

Baina potentzia horrek kostu bat eskatzen du. Eredu bat ehun mila milioi parametrorekin entrenatzeko, baliabide konputazional itzelak behar dira. Adibidez, Googlek 191 milioi dolar gastatu zituen Gemini 1.0 Ultra eredua entrenatzeko. Hizkuntza eredu handiek (LLM, ingeleseko siglengatik), halaber, potentzia konputazional oso handia behar dute eskaera bati erantzuten dioten bakoitzean; eta, beraz, energia kontsumitzaile nabarmenak dira. ChatGPTri eginiko kontsulta bakar batek Googlen bilaketa bat egitea baino hamar aldiz energia gehiago kontsumitzen du, gutxi gorabehera, Electric Power Research Institute erakundearen arabera.

Hori guztiagatik, zenbait ikertzailek tamaina txikian jarri dute orain fokua. IBM, Google, Microsoft eta OpenAIk, esaterako, hizkuntza eredu txikiak (SLM, ingeleseko siglengatik) atera dituzte duela gutxi. Eredu horiek milaka milioi parametro gutxi batzuk erabiltzen dituzte, kontrako LLM ereduek erabiltzen dituzten parametroen frakzio bat.

Eredu txikiak ez dira erabilera orokorreko tresnak, haien lehengusu nagusiagoak bezala, baina oso erabilgarriak izan daitezke eginkizun espezifiko eta zehatzagoetarako, hala nola elkarrizketak laburtzea, pazienteen galderei erantzutea arreta medikoko chatbot gisa, eta gailu adimendunetan datuak pilatzea. “Eginkizun askotarako, 8 mila milioi parametroko eredu bat oso egokia da”, adierazi du Zico Kolterrek, Carnegie Mellon Unibertsitateko zientzialari informatikariak. Ordenagailu eramangarri batean edo telefono mugikor batean ere exekutatu daitezke, datu lanketarako zentro handi batean exekutatu ordez. (Ez dago adostasunik “txiki”ren definizio zehatzari buruz, baina eredu berri guztiek, gehienez, 10 mila milioi parametro dituzte).

Eredu txiki horien entrenamendu prozesua optimizatzeko, ikertzaileek zenbait trikimailu erabiltzen dituzte. Eredu handiek Internetetik ateratzen dituzte prozesatu gabeko entrenamendurako datuak, baina datu horiek ez daude antolatuta eta ordenatuta, eta prozesatzeko zailak izan ohi dira. Hala ere, eredu handi horiek kalitate handiko datu multzo bat sor dezakete, eta datu horiek eredu txiki bat entrenatzeko erabil daitezke. Ikuspegi horri ezagutza destilazio esaten zaio. Horri esker, eredu handiagoak eraginkortasunez transmiti dezake bere entrenamendua, ikasle bati eskolak ematen dizkion irakasle baten antzera. “[SLMak] hain dira onak eredu oso txikiekin eta hain datu gutxirekin kalitate handiko datuak erabiltzen dituztelako, material desordenatua erabili ordez”, azaldu du Kolterrek.

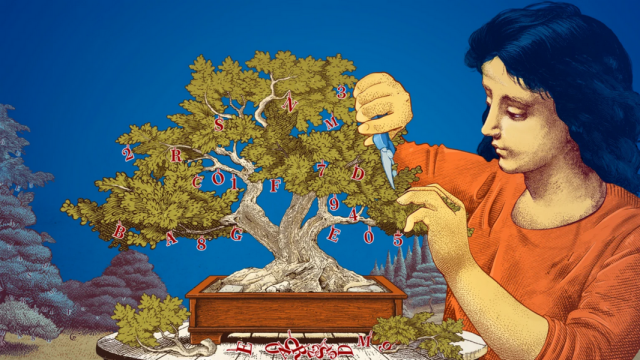

Ikertzaileak, halaber, eredu handiak oinarri hartuta eta horiek murriztuta eredu txikiak sortzeko moduak ikertzen hasi dira. Inausketa izeneko metodoan, sare neuronal batean (eredu handi baten azpian dagoen datu puntuen sare zabala) beharrezkoak edo eraginkorrak ez diren zatiak ezabatzen dira.

Inausketa bizitza errealeko sare neuronal batean inspiratu zen, giza garunean, hain zuzen. Izan ere, zahartzen garen heinean, giza garunak efizientzia handitzen du sinapsien arteko konexioak moztuta. Egungo inausketa ikuspegiek 1989ko artikulu batean dute oinarria. Artikulu horretan, Yann LeCun zientzialari informatikariak (egun Meta-n) argudiatu zuen entrenatutako sare neuronal baten parametroen % 90 arte ezaba litezkeela efizientzia galdu gabe. Metodoa «garuneko erasan optimo» izendatu zuen. Inausketak ikertzaileei lagun diezaieke hizkuntza eredu txiki bat doitzen eginkizun edo ingurune jakin baterako.

Eredu txikienek ideia berritzaileak modu ekonomikoan probatzeko aukera ematen diete hizkuntza ereduen funtzionamenduan interesa duten ikertzaileei. Eta eredu handiek baino parametro gutxiago dituztenez, horien arrazoiketa gardenagoa izan daiteke. “Eredu berri bat sortzeko, probak egin behar dira”, adierazi du Leshem Choshenek, MIT-IBMko Watson Adimen Artifizialeko Laborategiko zientzialari ikertzaileak. “Eredu txikiak erabilita, ikertzaileek esperimentuak egin ditzakete arrisku txikiagoarekin”.

Eredu handi eta garestiek, gero eta parametro gehiago dituztenek, erabilgarriak izaten jarraituko dute chatbot orokortuetarako eta halako aplikazioetarako, irudi sorgailuetarako eta farmakoen deskubrimendurako. Baina erabiltzaile askorentzat eredu txiki eta espezifiko batek handiek bezain ongi funtzionatuko du; eta, gainera, askoz errazagoa izango da ikertzaileentzat eredu hori entrenatu eta eraikitzea. “Eredu efiziente horiek dirua, denbora eta konputazioa aurrez dezakete”, adierazi du Choshenek.

Jatorrizko artikulua:

Stephen Ornes (2025). Why Do Researchers Care About Small Language Models?, Quanta Magazine, 2025eko martxoaren 10a. Quanta Magazine aldizkariaren baimenarekin berrinprimatua.